[ad_1]

«Cela fait partie de vous», a déclaré la patiente 6, décrivant la technologie qui lui a permis, après 45 ans d'épilepsie grave, de mettre un terme à ses crises invalidantes. Des électrodes avaient été implantées à la surface de son cerveau et envoyaient un signal à un appareil tenu à la main lorsqu'elles détectaient des signes d'activité épileptique imminente. En entendant un avertissement de l'appareil, le patient 6 a su prendre une dose de médicament pour mettre fin à la crise.

«On y grandit progressivement et on s'y habitue, alors ça fait partie de la vie de tous les jours», a-t-elle confié à Frederic Gilbert, éthicien qui étudie les interfaces cerveau-ordinateur (BCI) à l'Université de Tasmanie à Hobart, en Australie. "C'est devenu moi", dit-elle.

Gilbert interviewait six personnes ayant participé au premier essai clinique d'un BCI prédictif pour aider à comprendre comment l'utilisation d'un ordinateur surveillant l'activité du cerveau affecte directement des individus psychologiquement.. L’expérience de la patiente 6 était extrême: Gilbert décrit sa relation avec son BCI comme une «symbiose radicale».

La symbiose est un terme emprunté à l'écologie qui signifie la coexistence intime de deux espèces pour un avantage mutuel. Alors que les technologues s’efforcent de connecter directement le cerveau humain aux ordinateurs, il est de plus en plus utilisé pour décrire la relation potentielle des humains avec l’intelligence artificielle.

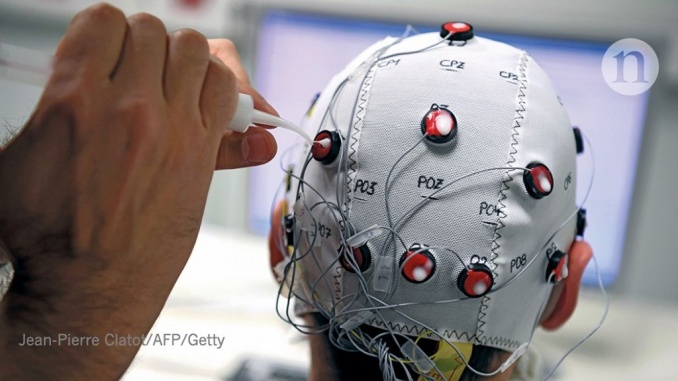

Les technologies d’interface sont divisées en deux catégories: celles qui «lisent» le cerveau pour enregistrer l’activité du cerveau et en décoder le sens, et celles qui «écrivent» dans le cerveau pour manipuler l’activité dans des régions spécifiques et affecter leur fonctionnement.

La recherche commerciale est opaque, mais on sait que les scientifiques de la plate-forme de médias sociaux Facebook étudient des techniques de lecture du cerveau à utiliser dans les casques pour convertir l’activité cérébrale des utilisateurs en texte. Des sociétés de neurotechnologie telles que Kernel à Los Angeles, en Californie, et Neuralink, fondée par Elon Musk à San Francisco, en Californie, prédisent un couplage bidirectionnel dans lequel les ordinateurs répondent à l’activité cérébrale des personnes et insèrent des informations dans leurs circuits neuronaux.

Les chercheurs en neuroéthique observent attentivement ce travail, un sous-domaine de la bioéthique qui est apparu au cours des 15 dernières années pour veiller à ce que les technologies qui affectent directement le cerveau soient développées de manière éthique.

"Nous ne voulons pas être le chien de garde de la neuroscience, ni surveiller la manière dont la neurotechnologie devrait être développée", a déclaré le neuroéthicien Marcello Ienca à l'Ecole Polytechnique Fédérale de Zurich. Ceux qui travaillent sur le terrain souhaitent plutôt que l’éthique soit intégrée aux étapes initiales de la conception et du développement de telles technologies, afin d’en maximiser les avantages et d’identifier et de minimiser les dommages potentiels, que ce soit pour les individus ou pour la société en général.

Les neuroéthiciens sont de plus en plus présents dans les milieux cliniques, où ils travaillent avec des scientifiques, des ingénieurs et des médecins qui développent des approches technologiques pour traiter les maladies neuropsychiatriques. Ils suivent de près l’utilisation croissante d’électrodes implantées dans le cerveau pour manipuler l’activité neuronale – une forme de base de la technologie d’écriture cérébrale – pour réprimer les manifestations de maladies telles que la maladie de Parkinson et l’épilepsie. Ils travaillent également dans des laboratoires qui développent des technologies de lecture cérébrale afin de permettre aux personnes paralysées de contrôler les prothèses et de générer un discours par la pensée.

Déjà, il est clair que la fusion des technologies numériques avec les cerveaux humains peut avoir des effets provocateurs, en particulier sur le libre arbitre des individus – leur capacité à agir librement et selon leurs propres choix. Bien que la priorité des neuroéthiciens soit d’optimiser la pratique médicale, leurs observations orientent également le débat sur le développement des neurotechnologies commerciales.

Changer les mentalités

À la fin des années 1980, des scientifiques français ont inséré des électrodes dans le cerveau de personnes atteintes de la maladie de Parkinson à un stade avancé. Ils visaient à faire passer les courants électriques dans des régions qui, à leur avis, provoquaient des tremblements, afin de supprimer l'activité neurale locale. Cette stimulation cérébrale profonde (DBS) pourrait avoir une efficacité saisissante: des tremblements violents et débilitants s’atténuent souvent au moment où les électrodes sont activées.

La Food and Drug Administration des États-Unis a approuvé l’utilisation du DBS chez les personnes atteintes de la maladie de Parkinson en 1997. Depuis lors, la technologie est utilisée dans d’autres conditions: le DBS a été approuvé pour le traitement du trouble obsessionnel compulsif et de l’épilepsie. utiliser dans des conditions de santé mentale telles que la dépression et l'anorexie.

Parce que c'est une technologie qui peut modifier de manière puissante l'activité de l'organe qui génère notre sens de la personnalité, la DBS suscite des préoccupations, contrairement aux autres traitements. «Cela soulève des questions sur l’autonomie car elle module directement le cerveau», déclare Hannah Maslen, neuroéthicienne à l’Université d’Oxford, au Royaume-Uni.

Des rapports ont fait état d'une minorité de personnes qui subissent un SCP pour la maladie de Parkinson qui devient hypersexuel ou qui développent d'autres problèmes de contrôle des impulsions. Une personne souffrant de douleur chronique est devenue profondément apathique après le traitement par DBS. «La SCP est très efficace, dit Gilbert, au point qu’elle peut déformer la perception d’eux-mêmes des patients.» Certaines personnes ayant reçu une SCP pour dépression ou trouble obsessionnel compulsif ont déclaré que leur sens de l’agence était devenu confus.. «Vous vous demandez simplement combien vous êtes, dit l'un d'eux. «Quelle est la part de mon schéma de pensée? Comment ferais-je si je n’avais pas le système de stimulation? Vous vous sentez un peu artificiel. "

Les neuroéthiciens ont commencé à noter la nature complexe des effets secondaires de la thérapie. «Certains effets que l’on pourrait qualifier de changements de personnalité sont plus problématiques que d’autres», explique Maslen. Une question cruciale est de savoir si la personne qui subit une stimulation peut réfléchir à la manière dont elle a changé. Gilbert, par exemple, décrit un patient DBS qui a commencé à jouer de façon compulsive, faisant sauter les économies de sa famille et semblant ne pas s'en soucier. Il ne pouvait que comprendre à quel point son comportement était problématique lorsque la stimulation était désactivée.

De tels cas soulèvent de sérieuses questions sur la manière dont la technologie peut affecter la capacité d’une personne à donner son consentement à un traitement ou à la poursuite de ce traitement. Si la personne qui subit un SCP est disposée à continuer, un membre de la famille ou un médecin concerné devrait-il être en mesure de l'annuler? Si une personne autre que le patient peut mettre fin au traitement contre son gré, cela signifie que la technologie dégrade la capacité de la personne à prendre des décisions elle-même. Cela suggère que si une personne pense d'une certaine manière uniquement lorsqu'un courant électrique modifie son activité cérébrale, ces pensées ne reflètent pas un soi authentique.

Ces dilemmes sont les plus épineux lorsque le traitement a pour objectif explicite de modifier les traits ou comportements qui contribuent au sens de l’identité d’une personne, tels que ceux associés à l’état de santé mentale anorexie mentale. «Si, avant le traitement DBS, un patient disait:« Je suis quelqu'un qui valorise la minceur par rapport à tout le reste », puis vous le stimulez et son comportement ou ses perspectives sont modifiés», déclare Maslen. «Il est important de savoir si de tels changements sont approuvés par le patient. "

Elle suggère que, lorsque les modifications sont alignées sur les objectifs thérapeutiques, «il est parfaitement cohérent qu'un patient puisse être satisfait de la manière dont la DBS les modifie». Avec d'autres chercheurs, elle travaille à la conception de meilleurs protocoles de consentement pour la DBS, y compris des consultations approfondies dans dont tous les résultats possibles et les effets secondaires sont explorés en profondeur.

Lire le cerveau

Observer une personne atteinte de tétraplégie porter un verre à la bouche à l'aide d'un bras robotisé contrôlé par BCI est spectaculaire. Cette technologie en évolution rapide consiste à implanter un ensemble d’électrodes sur ou dans le cortex moteur d’une personne, une région du cerveau impliquée dans la planification et l’exécution de mouvements. L'activité du cerveau est enregistrée pendant que l'individu s'engage dans des tâches cognitives, telles qu'imaginer qu'il bouge sa main, et ces enregistrements sont utilisés pour commander le membre robotique.

Si les neuroscientifiques pouvaient discerner sans ambiguïté les intentions d’une personne à partir de l’activité électrique bavarde qu’elle enregistre dans le cerveau, puis s’assurer que cela correspond aux actions du bras robotique, les préoccupations éthiques seraient minimisées. Mais ce n'est pas le cas. Les corrélats neuronaux des phénomènes psychologiques sont inexacts et mal compris, ce qui signifie que les signaux du cerveau sont de plus en plus traités par un logiciel d'intelligence artificielle (IA) avant d'atteindre les prothèses.

Philipp Kellmeyer, neurologue et neuroéthicien à l'Université de Fribourg en Allemagne, explique que l'application d'algorithmes d'intelligence artificielle et d'apprentissage automatique à l'analyse et au décodage de l'activité neuronale a «dynamisé tout le domaine». Il souligne les travaux publiés en avril dans lesquels un tel logiciel interprétait l'activité neuronale qui se produisait alors que les personnes épileptiques prononçaient des mots en silence, puis utilisait cette information pour générer des sons synthétiques.. «Il y a deux ou trois ans, nous aurions dit que ce ne serait jamais possible, ou que ce serait dans au moins 20 ans.»

Mais, dit-il, l'utilisation des outils d'intelligence artificielle introduit également des problèmes éthiques pour lesquels les régulateurs ont peu d'expérience. Les logiciels d'apprentissage automatique apprennent à analyser des données en générant des algorithmes imprévisibles et difficiles, voire impossibles à comprendre. Cela introduit un processus inconnu et peut-être inexplicable entre les pensées d'une personne et la technologie agissant en son nom.

Les développeurs se rendent compte que les prothèses fonctionnent plus efficacement lorsque certains calculs sont laissés à des dispositifs BCI, et lorsque ces dispositifs tentent de prédire ce que l'utilisateur fera ensuite. Les avantages des calculs de déchargement sont évidents. Des actes apparemment simples, tels que prendre une tasse de café, sont en réalité extrêmement complexes: les gens exécutent inconsciemment de nombreux calculs. Le fait de doter les prothèses de capteurs et de mécanismes permettant de générer de manière autonome des mouvements cohérents facilite la tâche des utilisateurs. Mais cela signifie également qu'une grande partie de ce que font les membres robotiques n'est pas réellement dirigée par l'utilisateur.

La nature prédictive de certains algorithmes utilisés pour aider les utilisateurs à utiliser des prothèses suscite de nouvelles inquiétudes. Les générateurs de texte prédictifs présents dans les téléphones mobiles soulignent ce problème: ils peuvent constituer des outils utiles, qui permettent de gagner du temps, mais toute personne qui a envoyé un message involontaire en raison d'une fonction de correction ou de remplissage automatique erronée sait comment les choses peuvent mal se passer.

De tels algorithmes tirent des leçons des données précédentes et guident les utilisateurs vers des décisions basées sur ce qu’ils ont fait dans le passé. Mais si un algorithme suggère constamment le mot ou l'action suivant d'un utilisateur et que celui-ci approuve simplement cette option, la paternité d'un message ou d'un mouvement deviendra ambiguë. Kellmeyer a déclaré: «À un moment donné, vous rencontrez ces situations très étranges d'agence partagée ou hybride.» Une partie de la décision revient à l'utilisateur et une partie à l'algorithme de la machine. "Cela crée un problème – un manque de responsabilité."

Maslen est confronté à ce problème dans le cadre d'un projet collaboratif appelé BrainCom, financé par l'Union européenne, qui développe des synthétiseurs de parole. Une telle technologie doit exprimer avec précision ce que les utilisateurs veulent dire pour être utile. Pour se protéger contre les erreurs, les utilisateurs pourraient avoir la possibilité d'approuver la diffusion de chaque mot – bien que le fait de transmettre constamment et secrètement des fragments de parole à l'utilisateur à des fins de révision pourrait rendre le système encombrant.

Des garanties telles que celle-ci seraient particulièrement importantes si les appareils avaient du mal à faire la distinction entre l'activité neuronale destinée à la parole et celle qui sous-tendait la pensée privée. Les normes sociales exigent que la frontière fondamentale entre la pensée privée et le comportement extérieur soit protégée.

Lecture, écriture et responsabilité

Comme les symptômes de nombreuses maladies du cerveau vont et viennent, les techniques de surveillance du cerveau sont de plus en plus utilisées pour contrôler directement les électrodes DBS, de sorte que la stimulation ne soit fournie que lorsque cela est nécessaire.

Les électrodes d'enregistrement – telles que celles qui avertissaient le patient 6 de crises imminentes – suivaient l'activité cérébrale pour déterminer quand les symptômes se produisaient ou étaient sur le point de se produire. Plutôt que de simplement alerter l'utilisateur sur la nécessité d'agir, ils déclenchent une électrode stimulante pour annuler cette activité. Si une crise est probable, le DBS atténue l'activité causative; si l'activité liée aux tremblements augmente, le DBS supprime la cause sous-jacente. Un tel système en boucle fermée a été approuvé par la Food and Drug Administration pour l’épilepsie en 2013, et de tels systèmes pour la maladie de Parkinson se rapprochent de la clinique.

Pour les neuroéthiciens, l’une des préoccupations est que l’insertion d’un dispositif décisionnel dans le cerveau d’une personne soulève la question de savoir si cette personne reste autonome, en particulier lorsque ces systèmes en boucle fermée utilisent de plus en plus un logiciel d’IA qui adapte ses opérations de manière autonome. Dans le cas d'un dispositif de surveillance de la glycémie contrôlant automatiquement la libération d'insuline pour traiter le diabète, cette prise de décision pour le compte d'un patient n'est pas controversée. Mais des interventions bien intentionnées dans le cerveau pourraient ne pas toujours être les bienvenues. Par exemple, une personne qui utilise un système en boucle fermée pour gérer un trouble de l'humeur pourrait se trouver dans l'incapacité de vivre une expérience émotionnelle négative, même dans une situation dans laquelle elle serait considérée comme normale, comme des funérailles. "Si vous avez un appareil qui améliore constamment votre réflexion ou votre prise de décision", dit Gilbert, "cela pourrait vous compromettre en tant qu'agent".

Le dispositif de gestion de l'épilepsie utilisé par le patient 6 et les autres receveurs que Gilbert a interrogé a été conçu pour permettre aux patients de rester sous contrôle en émettant un avertissement concernant des crises imminentes, ce qui permettait au patient de choisir de prendre un médicament ou non.

Malgré cela, pour cinq des six destinataires, l'appareil est devenu un décideur majeur dans leur vie. L'un des six généralement ignoré le périphérique. Le patient 6 a fini par l'accepter comme faisant partie intégrante de sa nouvelle identité, alors que trois destinataires, sans avoir l'impression que leur perception de soi avait été fondamentalement modifiée, étaient heureux de pouvoir compter sur le système. Cependant, un autre a été plongé dans la dépression et a déclaré que le dispositif BCI «m'a fait sentir que je n'avais aucun contrôle».

"Vous avez la décision ultime", dit Gilbert, "mais dès que vous réalisez que le périphérique est plus efficace dans le contexte spécifique, vous n'écoutez même pas votre propre jugement. Vous comptez sur l'appareil. "

Au-delà de la clinique

L'objectif des neuroéthiciens – maximiser les avantages des techniques émergentes et minimiser leurs dommages – est depuis longtemps ancré dans la pratique médicale. Le développement de la technologie grand public, en revanche, est notoirement secret et soumis à une surveillance minimale.

Avec les sociétés de technologie qui étudient actuellement la faisabilité d’appareils BCI grand public, Ienca pense que c’est un moment important. «Quand une technologie est à son stade germinal, dit-il, il est très difficile de prédire les résultats de cette technologie. Mais lorsque la technologie est mature – en termes de taille du marché ou de déréglementation – elle peut être trop enracinée dans la société pour l'améliorer ». À son avis, il existe désormais suffisamment de connaissances pour pouvoir agir de manière informée avant que la neurotechnologie ne soit largement utilisée.

Un problème que traite Ienca est la protection de la vie privée. «Les informations sur le cerveau sont probablement les informations les plus intimes et les plus privées», dit-il. Les données neuronales stockées numériquement peuvent être volées par des pirates ou utilisées de manière inappropriée par des entreprises auxquelles les utilisateurs accordent l'accès. Selon Ienca, les préoccupations des neuroéthiciens ont obligé les développeurs à veiller à la sécurité de leurs appareils, à protéger plus rigoureusement les données des consommateurs et à cesser de demander l’accès aux profils de réseaux sociaux et autres sources d’informations personnelles comme condition préalable à l’utilisation d’un appareil. Néanmoins, à mesure que la neurotechnologie des consommateurs gagne du terrain, s'assurer que les normes de confidentialité sont acceptables reste un défi.

La protection de la vie privée et le respect de l’agence figurent en bonne place dans les recommandations de divers groupes de travail, notamment des projets de grande envergure en neurosciences et des panels organisés par des organismes indépendants. Mais Kellmeyer pense qu'il reste encore beaucoup de travail à faire. «La matrice de l'éthique traditionnelle, qui met l'accent sur l'autonomie, la justice et les concepts connexes, ne sera pas suffisante», a-t-il déclaré. «Nous avons également besoin d'une éthique et d'une philosophie d'interaction homme-technologie.» De nombreux neuroéthiciens pensent que la capacité d'accéder directement au cerveau nécessitera une mise à jour des droits fondamentaux de l'homme.

Maslen aide déjà à façonner la réglementation des dispositifs BCI. Elle discute actuellement avec la Commission européenne de la réglementation qu'elle mettra en œuvre en 2020 et qui couvre les dispositifs de modulation du cerveau non invasifs vendus directement aux consommateurs. Maslen s'est intéressé à la sécurité de ces appareils, qui n'étaient couverts que par des règles de sécurité superficielles. Bien que ces dispositifs soient simples, ils font passer des courants électriques à travers le scalps des personnes pour moduler l’activité cérébrale. Maslen a découvert des cas de brûlures, de maux de tête et de troubles visuels. Elle a également déclaré que des études cliniques ont montré que, bien que la stimulation électrique non invasive du cerveau puisse améliorer certaines capacités cognitives, cela peut se faire au détriment de déficits d'autres aspects de la cognition.

Maslen et ses collègues ont rédigé un document d'orientation destiné aux régulateurs européens qui examinaient la réglementation de divers produits quasi médicaux tels que les dispositifs d'épilation au laser. Les régulateurs ont souscrit aux recommandations du document selon lesquelles les nouvelles réglementations devraient renforcer les normes de sécurité, mais également que (contrairement aux dispositifs médicaux), les consommateurs devraient rester libres de décider si les dispositifs apportent les gains revendiqués par leurs fabricants.

Le travail continu de Gilbert sur les effets psychologiques des dispositifs BCI met en évidence les enjeux pour les entreprises qui développent des technologies capables de façonner profondément la vie d’une personne. Il prépare actuellement un rapport de suivi sur la patiente 6. La société qui a implanté le dispositif dans son cerveau pour la libérer des crises a fait faillite. L'appareil a dû être retiré.

«Elle a refusé et a résisté aussi longtemps qu'elle a pu», déclare Gilbert, mais il a finalement fallu que cela disparaisse. C’est un destin qui a frappé les participants à des essais similaires, y compris les personnes dont la dépression avait été soulagée par le DBS. La patiente 6 a pleuré en informant Gilbert de perdre l'appareil. Elle a déploré sa perte. «Je me suis perdue», a-t-elle dit.

«C’était plus qu’un appareil», déclare Gilbert. "La société était propriétaire de l'existence de cette nouvelle personne."

[ad_2]